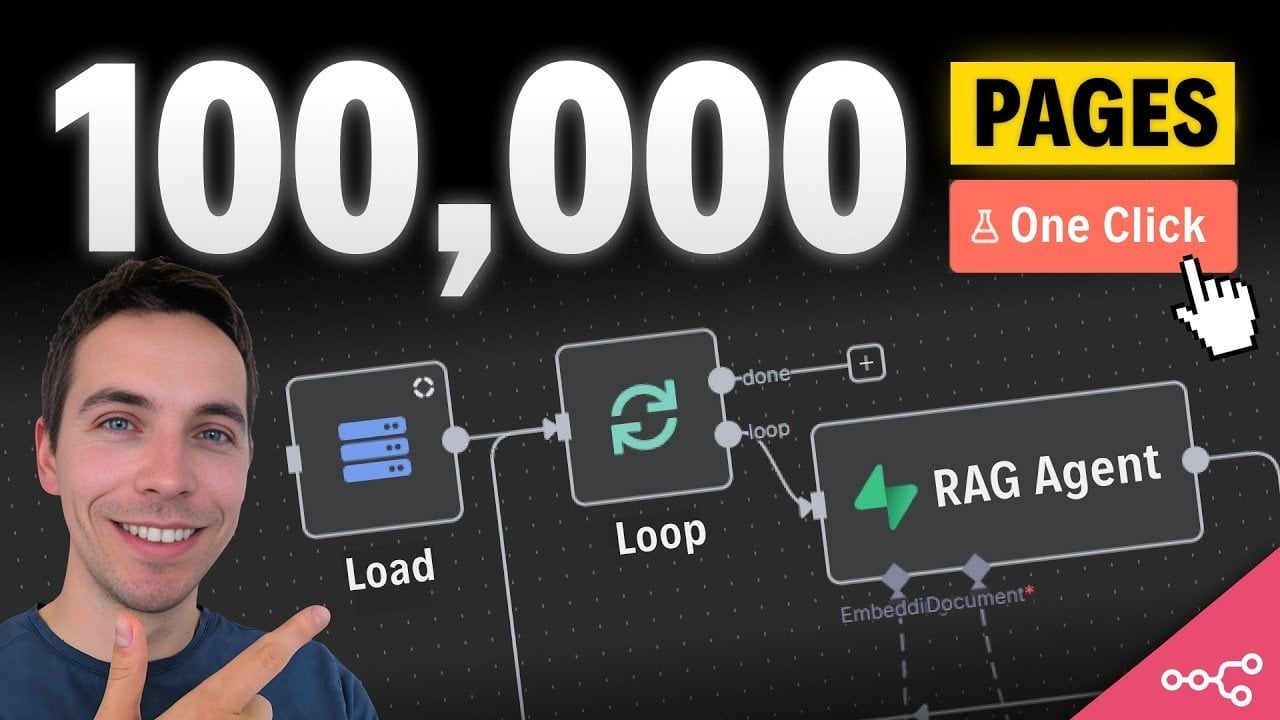

Освойте нескінченне масштабування автоматизацій n8n для підвищення ефективності робочих процесів

Як масштабувати n8n workflows для обробки величезних обсягів даних

Уявіть собі систему, що здатна обробляти десятки тисяч файлів одночасно, не пропускаючи жодного. Для багатьох масштабування n8n workflows до таких обсягів виглядає як справжнє мінне поле—переповнення пам’яті, обмеження швидкості та розповсюдження помилок, лише деякі з викликів. Але ось правда: правильними стратегіями ви можете перетворити свої робочі процеси в потужну систему, здатну впоратися з великими обсягами даних і процвітати під тиском. У цьому керівництві від експертів The AI Automators ви дізнаєтеся, як безмежно масштабувати ваші n8n RAG workflows.

Ключові виклики для масштабу

Масштабування робочих процесів означає подолання кількох критичних перешкод, що можуть вплинути на ефективність та надійність:

– Переповнення пам’яті: Обробка значних обсягів даних в одному робочому процесі може виснажити ресурси сервера, що призводить до збоїв.

– Обмеження бази даних: Багато зовнішніх сервісів, таких як OpenAI чи Supabase, встановлюють обмеження, що можуть сповільнити обробку.

– Пропагування помилок: Невирішені помилки можуть зірвати робочі процеси, спричиняти непередбачені зупинки.

– Інефективності єдиного процесу: Об’єднання всіх завдань в одному процесі може знизити швидкість обробки і масштабуємість.

Як побудувати оркестратор workflow

Оркестратор workflow є критичним елементом для ефективного розподілу завдань та забезпечення надійності на масштабі. Для цього розгляньте такі стратегії:

– Пакетна обробка: Розділіть файли на менші пакети, наприклад, по 50 файлів, щоб забезпечити паралельну обробку й зменшити навантаження на ресурси.

– Вебхуки: Замість суб-виконань використовуйте тригери вебхуків, щоб мінімізувати споживання ресурсів.

– Системи черг: Впровадьте систему черг для моніторингу виконання завдань та автоматичного повтору невдалих завдань.

– Обробка помилок: Створіть спеціалізований workflow для управління помилками і повторного виконання, щоб забезпечити надійність.

Оптимізація для максимального результату

Оптимізація workflows є критично важливою для обробки великих обсягів даних. Ось кілька ефективних стратегій:

– Робота з бінарними даними: Відокремте workflows для обробки бінарних даних, щоб зменшити використання пам’яті.

– Оптимізація бази даних: Використовуйте Supabase для управління таблицями виконання, забезпечуючи цілісність даних і масштабуємість.

– Пакетування і фільтрація: Групуйте файли в пакети і фільтруйте непотрібні дані для підвищення ефективності.

– Конкурентність: Використовуйте n8n у режимі черги, щоб розподілити навантаження та значно підвищити пропускну здатність.

Висновки та практичні уроки

Масштабування workflows – це процес, що вимагає постійного навчання та вдосконалення. Ось кілька ключових висновків:

– Управління даними виконання: Вимкніть збереження даних успішних виконань, щоб запобігти переповненню бази даних.

– Шар обробки помилок: Реалізуйте кілька механізмів обробки помилок для ефективного усунення збоїв.

– Сегментація даних: Уникайте перевантаження workflows надлишковими даними, обробляйте файли індивідуально або в менших групах.

– Моніторинг ресурсів: Регулярно моніторьте і масштабуйте обчислювальні ресурси Supabase.

– Налаштування інфраструктури: Постійно налаштовуйте workflows для адаптації до вимог зростаючого масштабу.

Будуючи масштабовану систему, враховуйте використання SFTP-серверів для швидшого доступу до файлів, оптимізацію середовищ та модульний дизайн workflows. Завдяки правильним стратегіям ваші робочі процеси досягнуть неперевершеної ефективності та масштабуємісті.